Kann ich die Stärken von Midjourney und Stable Diffusion vereinen?

Werkzeuge

Midjourney Stable Diffusion + Inpainting

Prozess

01 Generation des Basisbildes mit Midjourney text2img

02 Upload in Stable Diffusion Inpaint

03 Prompt Variationen erstellen

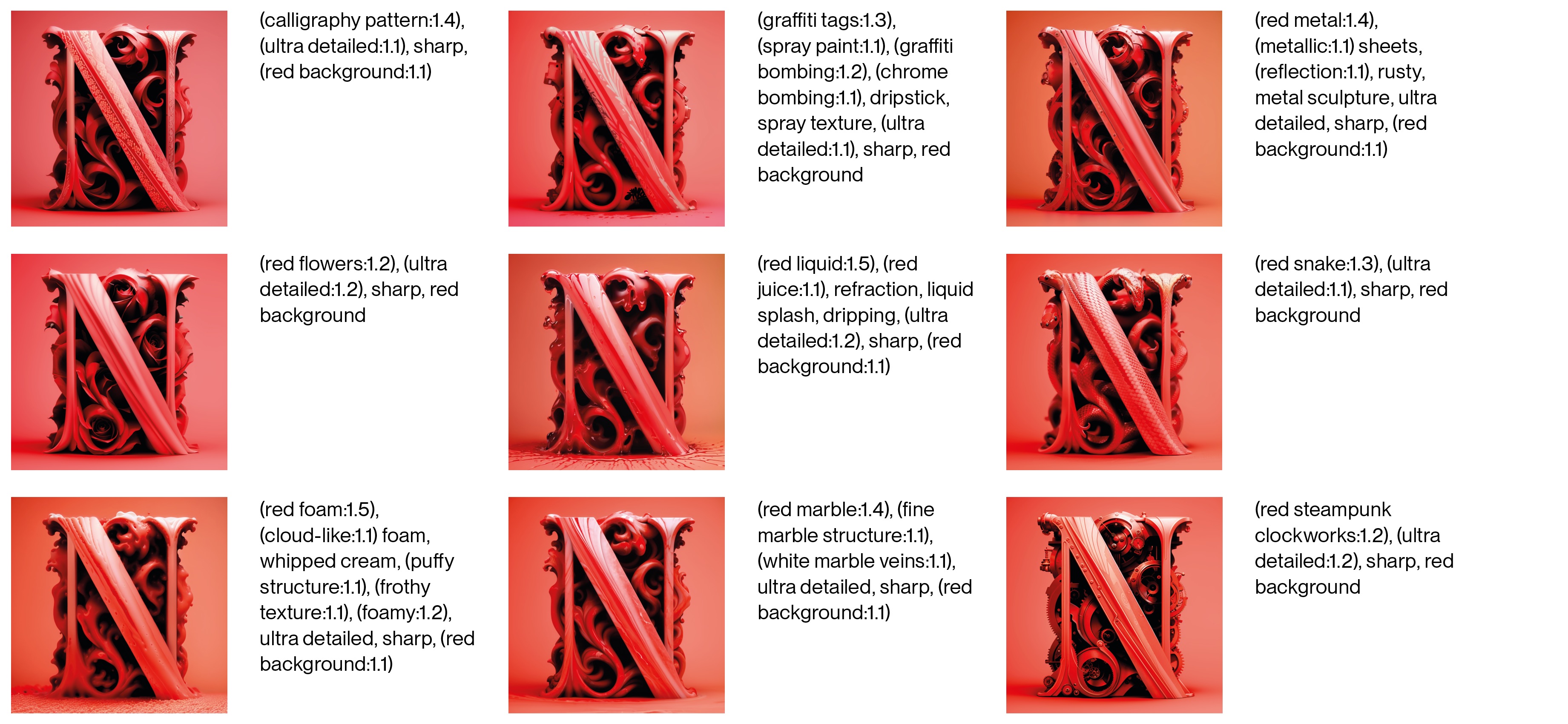

04 Testing

05 Export & Upscale

Prompt & Settings

[…] Negative prompt: worst quality, low quality, normal quality, lowres, ugly, watermark, qr code, cropped, cut of, childish, messy, sketch, amateur, low-res, ugly, deformed, mangled, disproportional, text, (signature:1.1) Steps: 25, Sampler: Euler a, CFG scale: 9, Seed: 3055960920, Size: 1024x1024, Model hash: 4199bcdd14, Model: revAnimated_v122, Denoising strength: 0.6, ControlNet 0: „preprocessor: tile_resample, model: controlnet11Models_tileE [e47b23a8], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: False, control mode: Balanced, preprocessor params: (512, 1, 64)“, Version: v1.3.0

Learnings

Das Programm Midjourney hat seine Stärke klar darin, bildlich überzeugende und beeindruckend detaillierte Ergebnisse zu liefern. Um eine hohe Bildqualität zu erreichen, muss man jedoch Abstriche in der Kontrolle machen. Möchte man die schnell und einfach zu erzielenden Ergebnisse aus Midjourney nutzen, aber weitere Anpassungen durchführen, ist Stable Diffusion in Verbindung mit ControlNet gut geeignet. Es lassen sich verschiedenste Stile durchspielen und es kann über mehrere Einstellungen bestimmt werden wie nah das Ergebnis an der ursprünglichen Komposition ist. Über die „denoising strenght“ hat man eine gute Kontrolle darüber, wie stark das Ergebnis vom Input abweicht. Über den CFG Scale bestimmt man wie nah sich Stable Diffusion an den Prompt halten soll.